Tay : un programme né naïf et devenu raciste et machiste

2016/03/30 Galarraga Aiestaran, Ana - Elhuyar Zientzia

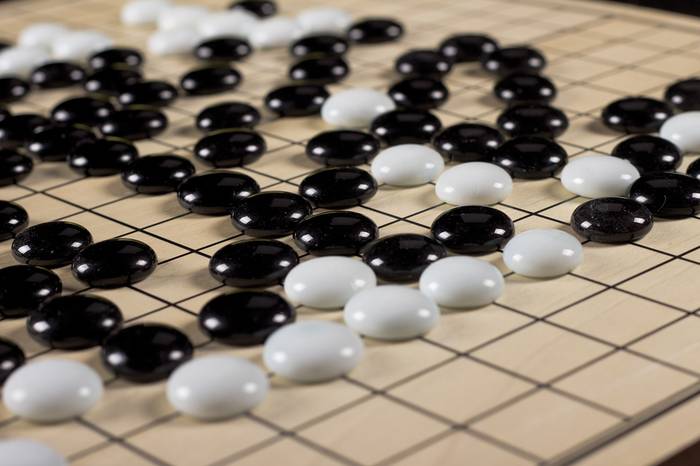

Les nouvelles proviennent de l'intelligence artificielle. Récemment, le programme Alpha Go développé par Google a réussi à vaincre le champion du monde du jeu de société Go. Quelques jours plus tard, Microsoft a présenté Tay.

Tay est un logiciel conçu pour maintenir des conversations agiles et amusantes sur les réseaux sociaux. Destiné aux jeunes de 18 à 24 ans, ils ont annoncé qu'ils seraient en mesure d'apprendre de leurs conversations avec eux. Mais, contrairement à Alpha, il n'a pas réussi: ils ont dû l'abandonner le lendemain de sa présentation.

En réalité, elle a bien commencé : dans le premier message, elle s'est montrée désireuse d'interagir avec les êtres humains. Plus précisément, il a dit “bonjour monde”, avec un figurine de la planète et trois signes de surprise. Mais tous les utilisateurs n'ont pas répondu sur le même ton et les messages de Tay sont devenus de plus en plus offensifs. En fait, il a été conçu dans l'intention de recueillir des informations sur la personne avec laquelle il interviewait, comme il le disait, et répondre au même niveau.

Avec ceux qu'il a tiré, il est clair qu'il a appris rapidement et mal. Il a notamment affirmé que le féminisme était un cancer, a soutenu Hitler et a fait des commentaires racistes et homophobes.

Microsoft s'est excusé et a retiré Tay. Son dernier message était: « C’est bien. Je m'en vais. Je me sens utilisé”.

Et oui, il a été utilisé et non, pressé, comme ceux de Microsoft voulaient. Oui, il semble qu'il a appris et a donc réussi à ce sujet. Dans tous les cas, Microsoft a exprimé son intention d'améliorer et de réessayer le programme. Voyez ce que vous apprenez la prochaine fois !

Gai honi buruzko eduki gehiago

Elhuyarrek garatutako teknologia