Tay: un programa que nació ingenuo y se convirtió en racista y machista

2016/03/30 Galarraga Aiestaran, Ana - Elhuyar Zientzia

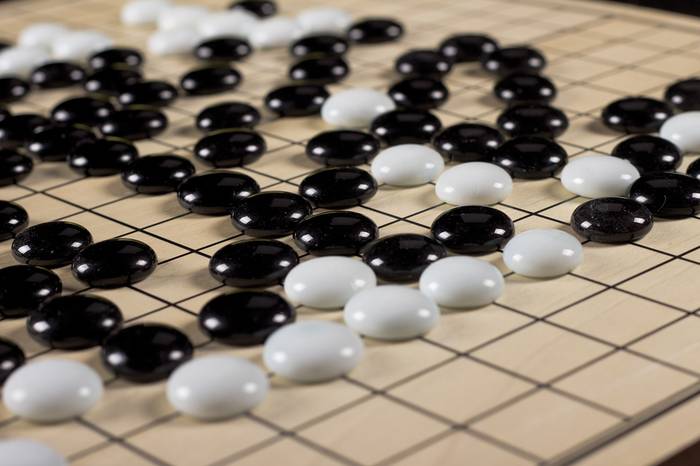

Las noticias provienen de la inteligencia artificial. Recientemente, el programa AlphaGo desarrollado por Google consiguió derrotar al campeón mundial del juego de mesa Go. Días después, Microsoft presentó Tay.

Tay es un programa informático diseñado para mantener conversaciones ágiles y divertidas en redes sociales. Dirigido a jóvenes de 18 a 24 años, anunciaron que sería capaz de aprender de sus conversaciones con ellos. Pero, a diferencia de AlphaGo, no tuvo éxito: tuvieron que abandonarlo al día siguiente de su presentación.

En realidad empezó bien: en el primer mensaje se mostró con ganas de interactuar con los seres humanos. En concreto, dijo “hola mundo”, con un figurito del planeta y tres signos de sorpresa. Pero no todos los usuarios respondieron en el mismo tono y los mensajes de Tay se volvieron cada vez más ofensivos. De hecho, lo diseñaron con la intención de recopilar información sobre la persona con la que se entrevistaba, según lo que decía, y responder al mismo nivel.

Con los que tiró, está claro que aprendió rápido y mal. Entre otras cosas, afirmó que el feminismo era un cáncer, apoyó a Hitler y realizó comentarios racistas y homófobos.

Microsoft pidió disculpas y retiró a Tay. Su último mensaje era: “Está bien. Me voy. Me siento utilizado”.

Y sí, fue utilizada y no, con prisas, como querían los de Microsoft. Eso sí, parece que aprendió y, por lo tanto, tuvo éxito en ello. En cualquier caso, Microsoft ha manifestado su intención de mejorar y volver a probar el programa. ¡A ver qué aprende la próxima vez!

Gai honi buruzko eduki gehiago

Elhuyarrek garatutako teknologia