Macro-ordinateurs et groupes d'ordinateurs

2002/04/01 Roa Zubia, Guillermo - Elhuyar Zientzia Iturria: Elhuyar aldizkaria

Qu'est-ce qu'un macroordinateur ? Une définition est: "Ordinateur haute capacité qui se connecte à d'autres ordinateurs. Leur taille dépend de la mémoire; les plus âgés ont une mémoire principale de plusieurs gigaoctets et plusieurs téraoctets de mémoire disque". Du point de vue actuel, il est possible que ces grandes machines sont définies avec une autre idée: un ordinateur qui fait des choses qui ne peuvent pas être faites avec l'ordinateur de la maison. Cependant, les deux définitions ne sont pas très concrètes.

Le premier macroordinateur (si possible) a été construit en 1975 par l'ordinateur américain Seymour Cray, qui lui a donné son nom: Cray 1. Il apporte des idées architecturales innovantes ; il était le premier ordinateur vectoriel, c'est-à-dire qu'il avait des registres travaillant avec des vecteurs (matrices unidimensionnelles). Cette idée est très utile pour la programmer en langage FORTRAN, qui était le langage le plus approprié pour le logiciel de la science, car avec les matrices les calculs étaient faciles. En outre, il disposait de processeurs en parallèle.

Des entreprises comme Alliant, Ardent ou Convex ont fabriqué des ordinateurs plus petits de la même philosophie et de nombreux nouveaux modèles de Cray ont été fabriqués. Actuellement, les 'successeurs' de l'ordinateur Cray 1 occupent environ 10% du marché du supercalcul. Cependant, chacune de ces machines à macroodencer a une capacité d'exploitation limitée, si une plus grande capacité est nécessaire, il faut former des ordinateurs.

Groupes d'ordinateurs

Succès des ordinateurs connectés. Et c'est que les macroordinateurs sont des machines très chères et pour l'entretien, il faut aussi beaucoup d'argent. Cependant, toute entreprise peut installer, gérer et utiliser le réseau d'ordinateurs 'petits' pour réaliser ces travaux gigantesques. Ainsi, au lieu d'utiliser un ordinateur avec plus d'un processeur, il a travaillé sur la façon de travailler en parallèle pour de nombreux ordinateurs d'un même processeur.

Chaque ordinateur d'un groupe reçoit le nom de noeud et peut avoir des centaines connectés à ce réseau. Vous pouvez également connecter des ordinateurs. La structure regroupant 16 groupes est appelée constellation. Vu tout cela, il est facile de comprendre qu'un macroordinateur n'a pas la même capacité de calcul que plusieurs groupes. En outre, une équipe informatique est accessible à une entreprise, tant du point de vue de la machine que de l'entretien, si elle est connectée à des réseaux d'autres entreprises le coût est distribué.

Politique de calcul

Dans les années 80, les gouvernements ont lancé de nombreux centres de supercalcul avec des macro-ordinateurs. Les entreprises qui ne pouvaient pas payer ce type de machines avaient la possibilité de se connecter à ces centres. Les gouvernements géraient donc les plus grands besoins informatiques des entreprises.

Mais dans ces années ont été développés les ordinateurs plus petits (ordinateurs personnels, entre autres) et l'idée de groupes d'ordinateurs. Peu à peu, les ressources nécessaires pour former les réseaux ont été couvertes. À la fin des années 1990, les entreprises avaient perdu la tendance aux centres de supercalcul. Les groupes avaient d'importants avantages : ils les géraient soi-même, la dépendance du gouvernement disparaissait et l'ordinateur ne devait pas être partagé. En conséquence, la capacité de calcul était plus grande.

Les gouvernements ont eu recours à la réduction du nombre de centres. Aujourd'hui, dans de nombreux États, il y en a peu parce qu'ils sont encore nécessaires pour certaines tâches (l'exemple est le projet Blue Gene). Certains centres sont devenus des bases de données publiques, mais la tendance de la plupart des groupes de chercheurs est d'avoir des ordinateurs privés. Quelle sera la principale opportunité pour l'avenir? Dans quelques décennies la situation peut changer.

Blue Gene : application pour brûler les puces

Au-delà de l'informatique théorique, il vaut la peine d'analyser l'énorme capacité des macro-ordinateurs. La mise en service de ces machines est coûteuse, il faut donc les utiliser, par exemple, étant donné que ces ordinateurs nécessitent des systèmes de climatisation spéciaux.

Que faut-il calculer sur ces grandes machines? Le projet Blue Gene lancé par IBM en 1999 est un bon exemple. Ce projet a été lancé pour enquêter sur l'un des problèmes les plus importants de la biochimie : le pliage des protéines. Pour aborder ce travail a été conçu un ordinateur avec une nouvelle architecture, dont le deuxième objectif est d'analyser l'efficacité de la nouvelle architecture.

Pourquoi faut-il étudier comment les protéines sont pliées? Il est facile, parce que les protéines sont responsables des réactions chimiques du corps. Si les protéines se "détériorent", il ya des maladies graves qui se détériorent souvent par un mauvais pliage. Nous savons que des maladies comme la maladie d'Alzheimer, l'hémophilie et d'autres concernent des protéines mal pliées.

Problème de formage

En général, les protéines sont des chaînes d'acides aminés. Il existe 20 types d'acides aminés dont la protéine présente des caractéristiques chimiques selon sa séquence. Mais la chimie détermine non seulement la séquence, mais la localisation spatiale des acides aminés est très importante. Les acides aminés très éloignés de la chaîne doivent être physiquement proches pour pouvoir remplir leur fonction, c'est-à-dire que la chaîne doit être pliée en trois dimensions correctement. Si une mauvaise conformation est prise, la protéine ne pourra pas fonctionner.

Mais comme la protéine est synthétisée, comment savez-vous quelle est sa conformation? Quel modèle continue pour plier des protéines ? Si nous le savions, nous inventerions des protéines pour produire la réaction chimique désirée avec la définition simple de la séquence. Blue Gene essaie de trouver ces modèles.

Grands nombres

Les protéines contiennent des centaines d'acides aminés. Par exemple, l'hémoglobine, une protéine qui transporte l'oxygène dans le sang, contient 612 acides aminés. L'angle dièdre entre trois acides aminés consécutifs peut avoir de nombreuses valeurs, de sorte que la protéine peut contenir des millions de structures spatiales. Seule une d'entre elles est adéquate

Les scientifiques proposent des modèles de processus de pliage des protéines, mais la capacité de calcul et la mémoire nécessaires pour prouver qu'ils sont ou ne sont pas corrects. Le travail d'un macroordinateur est indispensable. La société IBM a conçu un grand ordinateur avec une architecture unique: Blue Gene. Dans ce projet, on travaillera le modèle d'une protéine de taille moyenne contenant 300 acides aminés.

Lecteurs rapides

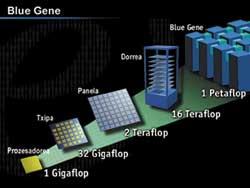

Blue Gene a été conçu pour être 500 fois plus rapide que l'ordinateur le plus rapide au monde. Comment est-il arrivé ? Sur de nombreux ordinateurs, le plus de temps nécessaire pour accéder aux données des puces de mémoire. Le projet Blue Gene a conçu des puces pour faire face à ce problème.

Chaque puce se compose de deux processeurs: l'un de calcul et l'autre de communication. Chaque groupe de puces prend en charge une partie du calcul complet. Cette stratégie accélère considérablement la capacité de calcul. Dans le cas des protéines, par exemple, les fichiers de travail doivent être très grands (fichiers qui restent pendant les calculs), et la durée du travail dépend finalement du temps que nous recherchons les données dont nous avons besoin.

Dans des applications complexes, les ordinateurs doivent effectuer des millions d'opérations arithmétiques dans les plus brefs délais. Pour cela, il y a environ quarante ans, les informaticiens ont inventé des ordinateurs vectoriels. Ces ordinateurs, au lieu d'utiliser des nombres simples, utilisent des vecteurs, c'est-à-dire des listes de nombres (pour ordinateurs, tableaux unidimensionnels).

Les ordinateurs vectoriels utilisent des lignes de pipes pour un calcul rapide. L'idée de ces pipe-line est très simple, c'est le même principe que la fabrication de séries. Avec un exemple, il est facilement compris. Supposons que nous devons calculer la différence entre les données de deux listes de nombres, pour cela il faut suivre quatre étapes : a) prendre un numéro de chaque liste, b) soustraire c) si le résultat de la soustraction est négatif, changer le signe et d) stocker le résultat en mémoire. Si chaque étape est effectuée en microseconde, pour traiter une paire de nombres, quatre microsecondes sont nécessaires.

Les listes que nous utiliserons sont: 10, 3, 2, 6, 7, 1, 5, 10, … et 7, 8, 14, 5, 3, 4, 5, 6, …

Au lieu de cela, sur une pipe-line, lorsque la première paire de nombres a terminé la première étape, il va à la deuxième, mais une deuxième paire de nombres entrent dans la première étape. Ainsi, à chaque microseconde, les murs intérieurs avanceront une étape et une paire sera intégrée dans la première étape libre. De cette façon, l'opération de la première paire nécessitera trois microsecondes, mais celle de la deuxième paire se terminera par la quatrième microseconde (et non par la sixième, comme si elles se réalisaient une à une).

C'était un exemple simple, mais il faut noter que les ordinateurs effectuent des opérations arithmétiques avec des numéros à virgule. (L'écriture à virgule mobile pour représenter un nombre utilise une mante et une caractéristique, à savoir, est une écriture de type 0,233 x 10 3).

L'arithmétique de ces nombres exige plus d'étapes que les nombres entiers. Les macro-ordinateurs vectoriels intègrent des systèmes pipe-line de calcul à virgule mobile. En outre, en combinant des vecteurs complets avec des enregistrements pour le traitement des nombres simples, ils peuvent effectuer des opérations arithmétiques extrêmement rapides. Le plus célèbre des premiers macroordinateurs de ce type, Cray 1, date de 1976.

Souvent, un groupe de petits ordinateurs peut travailler sur un ordinateur vectoriel. C'est la philosophie principale des groupes d'ordinateurs. Cependant, tous les ordinateurs qui composent le groupe doivent être en quelque sorte connectés à un réseau. Chaque ordinateur participant est appelé nœud. Mais où est le logiciel dont tous les nœuds ont besoin ? Utiliserez-vous la mémoire commune ou chaque noeud utilisera-t-il la vôtre ? Du point de vue architectural de tout le système, il existe trois formes d'organisation. Disques partagésCe type d'ordination est très utilisé. Le réseau dispose de périphériques d'entrée et de sortie généraux, accessibles depuis chaque nœud. Ces appareils comprennent des fichiers et des bases de données. Ainsi, le système n'a pas besoin de partager des mémoires de nœuds. Le principal problème de ce système est la disponibilité de tous les nœuds. À un moment donné, tous les nœuds peuvent écrire ou lire simultanément sur les disques généraux. Pour pouvoir contrôler tout cela, un mécanisme de synchronisation est nécessaire : le gestionnaire de verrouillage. La détérioration d'un nœud dans ces systèmes n'affecte pas les autres. Cela offre une grande disponibilité au système, même si cette fonctionnalité ralentit parfois le travail en raison des rétrécissements générés par l'activité du gestionnaire de blocage. Systèmes sans partageDans ces systèmes, aucun disque n'est disponible pour les nœuds. Ainsi, dans ces systèmes, le nombre de nœuds n'est pas aussi limité qu'auparavant. Ces systèmes ont des centaines de nœuds. Systèmes miroirsBien que dans ces systèmes les données soient stockées sur un disque général, elles sont copiées en une seconde pour augmenter la disponibilité. Normalement, on ne travaille pas sur cette copie, sauf si le disque original est endommagé. Si elle tombe en panne, cette organisation récupère les données très rapidement. Ces systèmes n'ont généralement que deux nœuds. Beaucoup de serveurs qui supportent le réseau Internet sont des systèmes de ce type. |

Deux fois par an, pendant les mois de juin et novembre, des congrès de supercalcul sont organisés pour faire connaître ce qui s'est passé dans ce domaine. Le dernier congrès de novembre de l'année dernière a eu lieu aux États-Unis, Denver, et le précédent, juin, à Heilderberg, en Allemagne. Ces congrès rassemblent les données des centres de supercalcul et actualisent la liste Top500. Cette liste analyse les 500 centres de plus grande capacité et leurs caractéristiques. Les changements entre les différentes versions de la liste peuvent être consultés sur le site suivant: http://www.top500.org/ |

Quant aux grands centres de calcul, au Pays Basque, la tendance est la même que dans le reste du monde. Dans le passé, lorsque des centres de fonctionnement de macroordinateurs étaient mis en place, la Vice-conseillère de l'Industrie du Gouvernement Basque et le centre technologique Labein ont signé un accord pour l'installation d'un centre informatique. Il a été décidé de placer ce centre dans le parc technologique de Zamudio.

Un macroordinateur Convex a été mis en place et pourrait être utilisé dans plusieurs entreprises d'Euskal Herria. Les entreprises auxquelles il devait se connecter appartenaient principalement au domaine de l'ingénierie, dans le but de réaliser sur ce gigantesque ordinateur les grands calculs nécessaires à la conception.

La meilleure configuration de cette machine convex était l'ordinateur parallèle de 8 processeurs vectoriels. Au début, certaines entreprises ont eu un grand intérêt. Cependant, au lieu d'être un centre de supercalcul, la tendance générale était de chercher d'autres solutions (par exemple, des groupes d'ordinateurs gérés par soi-même). Pendant quelques années, il a été utilisé par plusieurs groupes de chercheurs de l'Université du Pays Basque, mais le centre de supercalcul a finalement été suspendu.

Gai honi buruzko eduki gehiago

Elhuyarrek garatutako teknologia