Dépasser les nouvelles limites d'Alpha Go par apprentissage automatique

Ils ont récemment annoncé pour la première fois qu'il a été en mesure de gagner un joueur professionnel du jeu de table Go, bien connu en Extrême-Orient. C'est la première fois que dans un jeu de ces caractéristiques on réussit à surmonter les humains avec des méthodes appelées des études automatiques. Mais ce ne sera pas le dernier.

Sur le chemin de l'intelligence des machines, c'est-à-dire de l'intelligence artificielle, il a été habituel d'essayer d'inventer des machines, des programmes ou des technologies qui gagnent les êtres humains dans des tâches ou des jeux qui ont été considérés comme complexes et simplement adaptés à la réalisation de cerveaux humains. Ainsi sont tombés une à une, limites qui semblaient impossibles à l'avance, et les ordinateurs ont dépassé l'homme dans plusieurs jeux: dans le jeu de trois bergers, la machine OXO, capable de faire les matches parfaits en 1952 et assurer au moins l'égalité; dans le jeu des dames, le programme chinois a battu le meilleur joueur de tous les temps, en 1994 (et la machine a réussi à être en mesure de faire un match parfait 2007

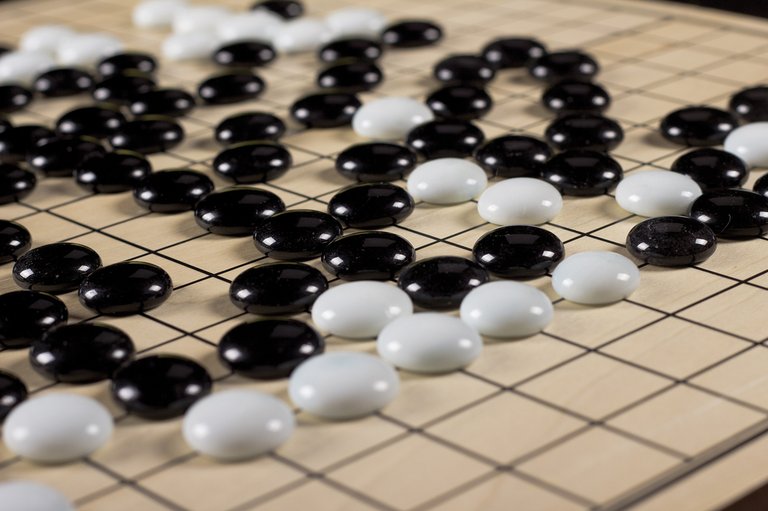

Le jeu Go était le prochain défi à relever par les machines. Bien que quelque peu inconnu dans notre pays, il est très répandu en Chine et au Japon et compte plus de 40 millions de joueurs dans le monde. Il se joue sur un tableau du tableau 19x19 dans lequel deux joueurs doivent placer les tuiles noires et blanches pour gagner les tuiles des autres et finir avec plus de tuiles que le reste. Un match peut durer plusieurs jours, mais les matchs sont limités à 16 heures. On calcule que dans le jeu Go on peut donner environ 2x10170 combinaisons possibles, plus que le carré du nombre d'atomes calculés dans l'univers! Et au moins 10100 fois plus de combinaisons qu'aux échecs! En raison de cette complexité, les chercheurs ne parvenaient pas à faire un programme qui gagnerait les joueurs professionnels dans le jeu Go. Jusqu'en octobre de l'année dernière. Puis, le système Alpha de Google a gagné pour la première fois un joueur professionnel Go.

Apprentissage automatique

Dans l'histoire de l'informatique, diverses façons de résoudre les problèmes ont été utilisées. De la manière la plus simple, les êtres humains codent directement, dans un programme, les décisions ou les coups à prendre dans chaque situation en fonction des conditions. Cela ne sert qu'aux problèmes les plus simples, mais au début des ordinateurs, on ne pouvait rien faire d'autre. Cependant, il a servi à surmonter le jeu de trois pasteurs et d'autres.

Une autre méthodologie est appelée « brute-force search », c'est-à-dire « recherche de force sauvage » ou recherche combinatoire ou profonde. Grâce à elle, il est analysé à chaque moment du match où ils peuvent prendre toutes les options possibles. Cependant, en fonction de la complexité du jeu, vous ne pouvez pas

analyser les chances de gagner ou vous ne pouvez pas atteindre la profondeur minimale nécessaire. Par exemple, il faut étudier un million de possibilités pour atteindre la profondeur de 4 joueurs, un milliard d'options pour 8 joueurs, un trillion pour le 12… Cependant, ce type de systèmes ont été utilisés beaucoup et avec succès. En définitive, Deep Blue utilisait cette méthode. Mais ce système de jeu Go a ses limites, car à chaque instant vous pouvez effectuer environ 250 jeux possibles.

Ainsi, le système le plus utilisé ces derniers temps pour résoudre ce type de jeux, ainsi que de nombreux autres problèmes complexes, comme beaucoup de ceux liés à la technologie linguistique et vocale, est l'apprentissage automatique. Dans l'apprentissage automatique, différentes méthodologies sont combinées avec un même fonctionnement: il existe certaines structures de données qui fournissent des entrées qui fournissent des sorties; ces structures sont données de nombreux exemples pour les entrées et les sorties dont elles auraient besoin et à travers des algorithmes adaptent leur structure pour donner les sorties que l'on souhaite obtenir. Par exemple, dans les échecs les entrées peuvent être les états de l'échiquier et les sorties, les meilleures jouées pour ces situations. Si on arrive à adapter les structures de données pour donner ces sorties face à ces entrées, dans la plupart des cas, ils seront en mesure de donner une réponse optimale même dans des situations nouvelles qui ne leur avait jamais été montré auparavant.

Dans le machine learning on a initialement utilisé des structures de données appelées neural network ou réseaux neuronaux qui essayent d'imiter le comportement des neurones des cerveaux humains. Dans les années 70, la recherche sur l'intelligence artificielle s'est éloignée de ces systèmes, mais à la fin des années 2000, l'intérêt pour les réseaux neuronaux, qui sont largement utilisés, a été relancé. Le système Alpha Go qui nous occupe est basé sur des réseaux neuronaux. Compte tenu de l'évolution des dernières années et des résultats obtenus avec le jeu Go, il semble que dans les années à venir, les recherches sur l'intelligence artificielle avanceront vers un apprentissage automatique.

...et au-delà!

L'intérêt pour l'apprentissage automatique et les réseaux neuronaux a été ressurgi car les puissants ordinateurs actuels ont permis des structures de données ou des réseaux neuronaux plus complexes. En particulier, dans le cas des réseaux neuronaux, les neurones artificiels peuvent maintenant être divisés en plusieurs couches, utiliser beaucoup plus de données pour former ou apprendre et résoudre des problèmes complexes.Ils s'appellent Deep neural network ou réseaux neuronaux profonds, et Alpha utilise une de ces caractéristiques.

Mais un réseau de neurones de ces caractéristiques pour le jeu Go, malgré l'entraînement avec 30 millions de joueurs humains, n'a pas obtenu de si bons résultats. Une autre technique utilisée était le reinforcement learning. Dans cette méthode, le système obtenu a été mis à jouer contre lui-même, de nombreux matches, et plus tard les mouvements de ces matches ont été utilisés pour former et améliorer le système par l'apprentissage automatique. Et une fois cela fait, ils ont réussi à construire Alpha Go.

Cela signifie que pour devenir un joueur artificiel a été utilisé un système d'apprentissage automatique, mais pas pour apprendre de l'homme, mais pour apprendre de lui-même! Les études initiales ont été réalisées à partir de parties humaines. Mais cela fonctionnerait sans eux ? Autrement dit, si avec une machine de départ très naïve ou aléatoire et jouant des matchs avec elle-même, nous nous mettions à apprendre et à améliorer constamment, le résultat serait-il le même ? Si oui, les conséquences seraient énormes.

En tout cas, en Octobre, le joueur qui a été vaincu par le système Alpha Go, Fan Hui, est un joueur professionnel de 2 jours en dépit d'être champion d'Europe. Mi-mars, le système Alpha Go affrontera Lee Se-dol, l'un des meilleurs joueurs de l'histoire et avec un classement de 9 dans (maximum existant) dans le parti public qui se tiendra en Corée du Sud. Le suivi du parti sera certainement d'un grand intérêt.

Buletina

Bidali zure helbide elektronikoa eta jaso asteroko buletina zure sarrera-ontzian